让照片跳起舞!阿里开源了:AnimateAnyone!

在数字时代,我们见证了技术的飞速发展,尤其是在人工智能领域。

兵马俑跳科目三、奶牛猫跳洗澡舞等视频我想大家都在短视频平台看到过,这背后使用的技术就是:AnimateAnyone

AnimateAnyone是什么?

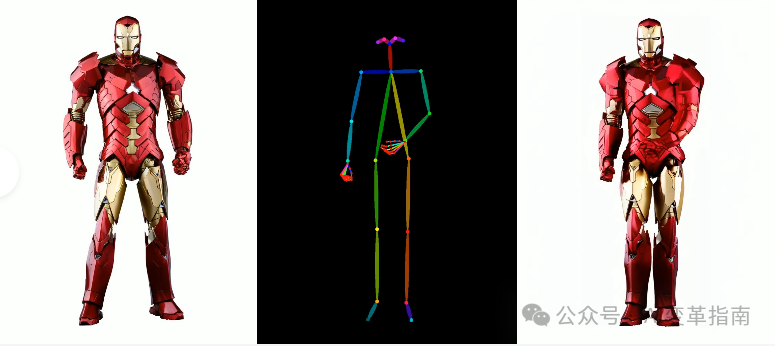

AnimateAnyone来自阿里通义实验室,是针对可控动画生成领域的一项研究工作。输入一张图片,和一个舞蹈视频,它能够将静态图像转换成连贯、可控制的视频。

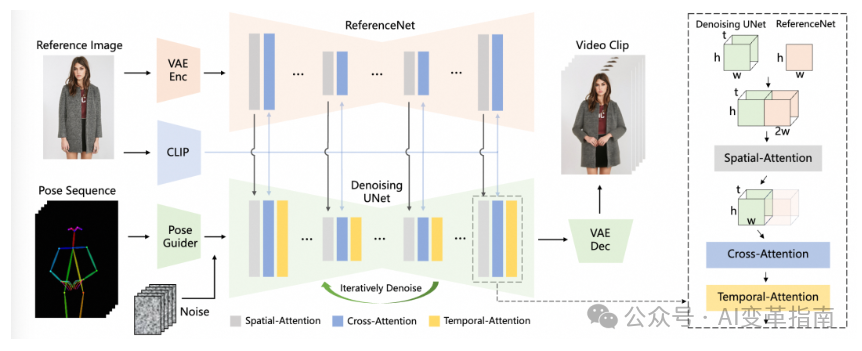

AnimateAnyone是一个开源框架,它利用扩散模型,结合了ReferenceNet、Pose Guider姿态引导器和时序生成模块等先进技术,能够在保持图像一致性、可控性和稳定性的同时,生成高质量的动态视频。

AnimateAnyone的工作原理

想象一下,我们有一种方法可以把一个人的照片变成动画。首先,我们用一个叫做“Pose Guider”的工具来记录这个人的姿势序列,就像是在告诉电脑这个人要怎么动。然后,我们加入一些“多帧噪声”,这就像是给电脑一些关于动作流畅度的提示。

接下来,有一个叫做“Denoising UNet”的部分来清理这些噪声,确保视频看起来不会乱七八糟。这个“Denoising UNet”有三个特别的注意力区域:空间注意力、交叉注意力和时间注意力。这就像是让电脑在不同的方向上专注,以便更好地理解动画应该怎么生成。

我们还会用到一张参考图片,从中提取细节特征和语义特征。细节特征帮助电脑理解图片的具体内容,而语义特征则帮助电脑理解图片的整体意义。这些特征被用来增强空间注意力和交叉注意力。

最后,时间注意力就像是电脑的记忆,它帮助电脑理解动画中的时间流逝。所有这些信息最终都会被一个叫做“VAE解码器”的工具转换成视频片段。

如何使用?

代码已开源,可以本地部署,或者线上体验。

部署方法:

需要本地具有python环境,要求3.10以上。

# [Optional] Create a virtual envpython -m venv .venvsource .venv/bin/activate# Install with pip:pip install -r requirements.txt# For face landmark extractiongit clone https://github.com/emilianavt/OpenSeeFace.git

https://github.com/MooreThreads/Moore-AnimateAnyone

项目地址:

https://humanaigc.github.io/animate-anyone/

苏公网安备

32050902101537号

苏公网安备

32050902101537号